redis-高可用篇

文章目录

主从复制

单点Redis的并发能力是由上限的,如果都存储在一台服务器上,出事了就会有很严重的影响。

- 如果出现了宕机,那么数据恢复需要时间,而且主进程在此期间不能服务新请求,

- 硬盘出了问题那就会造成数据丢失。

如何解决这种问题,并且还要进一步提高并发性?可以搭建主从模式,实现读写分离。

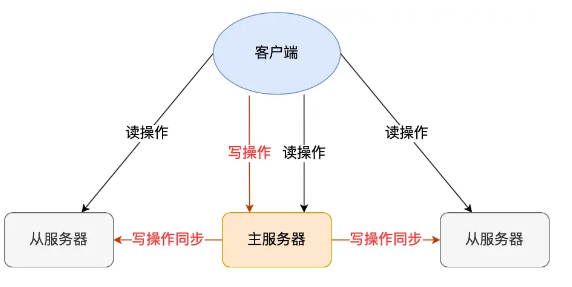

读写分离:

主服务器可以进行读写操作,当发生写操作时自动将写操作同步给从服务器,而从服务器一般是只读,并接受主服务器同步过来写操作命令,然后执行这条命令。也就是说,所有的数据修改只在主服务器上进行,然后将最新的数据同步给从服务器,这样就使得主从服务器的数据是一致的。

第一次同步

多台服务器之间要通过什么方式来确定谁是主服务器,或者谁是从服务器呢?

我们可以使用 replicaof(Redis 5.0 之前使用 slaveof)命令形成主服务器和从服务器的关系。

比如,现在有服务器 A 和 服务器 B,我们在服务器 B 上执行下面这条命令:

1 | # 服务器 B 执行这条命令 |

接着,服务器 B 就会变成服务器 A 的「从服务器」,然后与主服务器进行第一次同步。

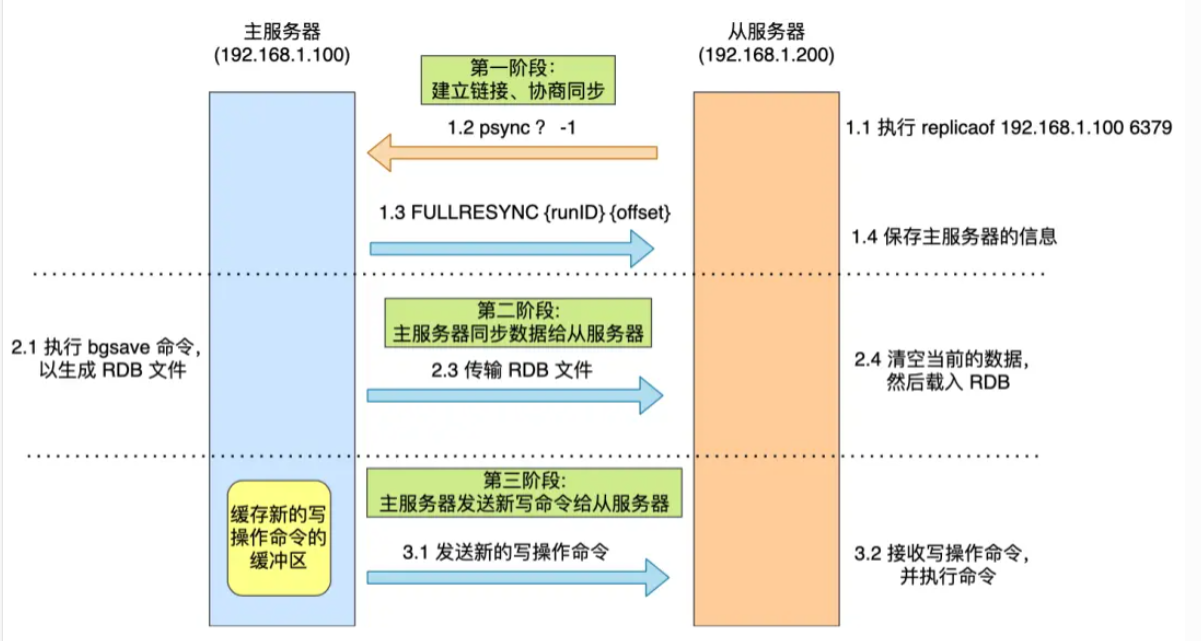

主从服务器间的第一次同步的过程可分为三个阶段:

- 第一阶段是建立链接、协商同步;

- 第二阶段是主服务器同步数据给从服务器;

- 第三阶段是主服务器发送新写操作命令给从服务器。

- 一个从服务器要加入主服务器的从节点,首先执行上面这条replicaof,告诉主服务器我是新加入的

- 然后建立连接。这里有两个关键参数replication id,标识一个数据集,每一个master都会有一个这个id,相当于标记了一块空间,当slave加入时,并不知道master的这个id,就给“?”,还有一个参数offset也就是偏移量,表示复制的进度,初始化为-1,(有点类似TCP的序号和确认号)。

执行psync命令,告诉主服务器一个从节点要建立连接了- 主服务器判断来的这个replication id是否是自己的,如果不是自己的说明是第一次加入的从服务器,返回前面的这两个值,自己的id和当前的复制进度。

- 从服务器收到响应之后会记录这两个值,准备进行全量复制

- 此时主服务器fork一个子进程完成bgsave命令,生成RDB文件,然后传输给从服务器。此时不会阻塞主进程,还是能接收新的数据,那么就需要一个数据结构来存这些刚刚加入,但是没有写入RDB文件的数据,这里就有一个replication buffer缓冲区用来存这些数据

- 从服务器收到了bump.rdb文件,然后进行载入,在此之前清空当前数据

- 对于主服务器在复制传输和子服务器重建过程中新到的数据,缓冲区内的数据发送新的写命令给从服务器。

第一阶段:建立链接、协商同步

执行了 replicaof 命令后,从服务器就会给主服务器发送 psync 命令,表示要进行数据同步。

psync 命令包含两个参数,分别是主服务器的 runID 和复制进度 offset。

runID,每个 Redis 服务器在启动时都会自动生产一个随机的 ID 来唯一标识自己。当从服务器和主服务器第一次同步时,因为不知道主服务器的 run ID,所以将其设置为 “?”。

offset,表示复制的进度,第一次同步时,其值为 -1。

主服务器收到 psync 命令后,会用 FULLRESYNC 作为响应命令返回给对方。

并且这个响应命令会带上两个参数:主服务器的 runID 和主服务器目前的复制进度 offset。从服务器收到响应后,会记录这两个值。

FULLRESYNC 响应命令的意图是采用全量复制的方式,也就是主服务器会把所有的数据都同步给从服务器。

所以,第一阶段的工作时为了全量复制做准备。

那具体怎么全量同步呀呢?我们可以往下看第二阶段。

第二阶段:主服务器同步数据给从服务器

接着,主服务器会执行 bgsave 命令来生成 RDB 文件,然后把文件发送给从服务器。

从服务器收到 RDB 文件后,会先清空当前的数据,然后载入 RDB 文件。

这里有一点要注意,主服务器生成 RDB 这个过程是不会阻塞主线程的,因为 bgsave 命令是产生了一个子进程来做生成 RDB 文件的工作,是异步工作的,这样 Redis 依然可以正常处理命令。

但是,这期间的写操作命令并没有记录到刚刚生成的 RDB 文件中,这时主从服务器间的数据就不一致了。

那么为了保证主从服务器的数据一致性,主服务器在下面这三个时间间隙中将收到的写操作命令,写入到 replication buffer 缓冲区里:

- 主服务器生成 RDB 文件期间;

- 主服务器发送 RDB 文件给从服务器期间;

- 「从服务器」加载 RDB 文件期间;

第三阶段:主服务器发送新写操作命令给从服务器

在主服务器生成的 RDB 文件发送完,从服务器收到 RDB 文件后,丢弃所有旧数据,将 RDB 数据载入到内存。完成 RDB 的载入后,会回复一个确认消息给主服务器。

接着,主服务器将 replication buffer 缓冲区里所记录的写操作命令发送给从服务器,从服务器执行来自主服务器 replication buffer 缓冲区里发来的命令,这时主从服务器的数据就一致了。

至此,主从服务器的第一次同步的工作就完成了。

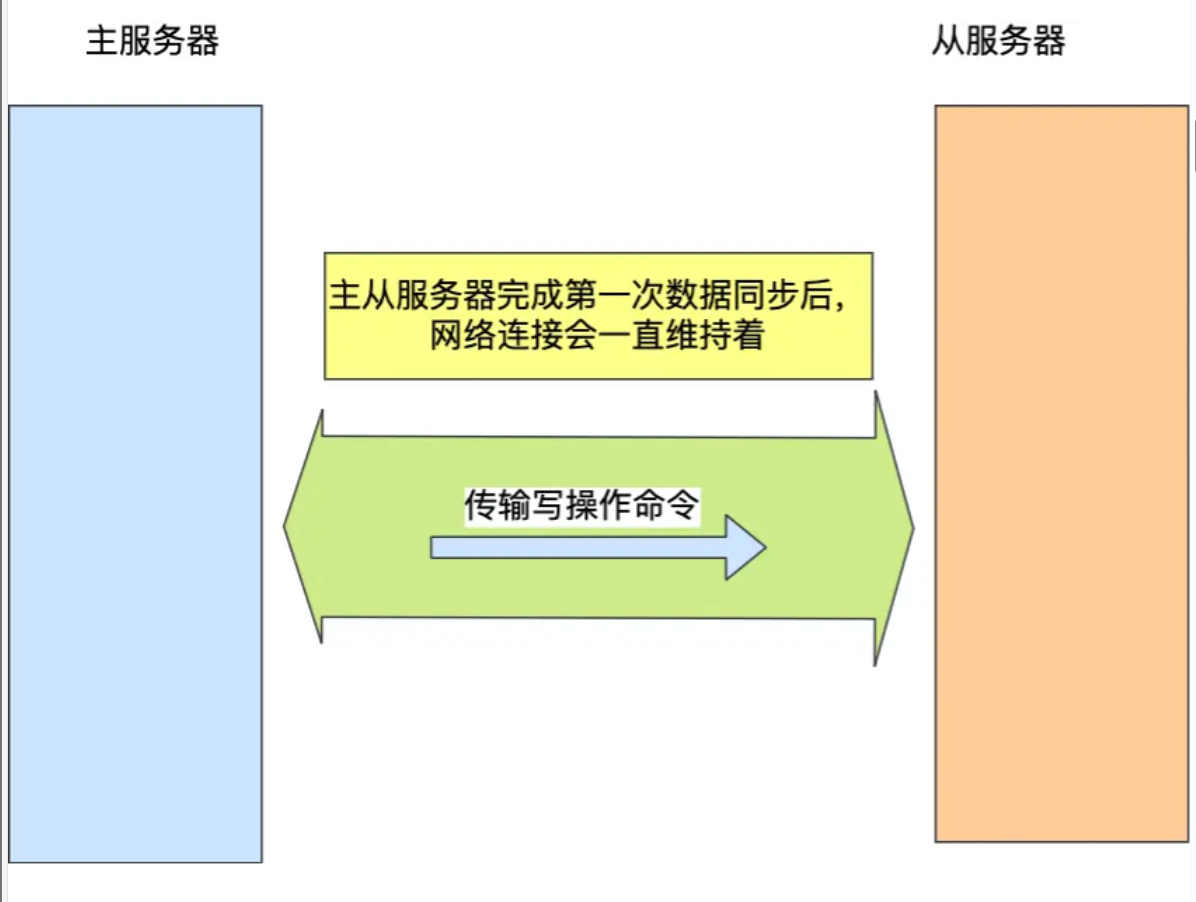

命令传播

主从服务器在完成第一次同步以后就会维护一个Tcp连接。

后续主服务器可以通过这个连接继续将写操作命令传播给从服务器,然后从服务器执行该命令,使得与主服务器的数据库状态相同。

而且这个连接是长连接的,目的是避免频繁的 TCP 连接和断开带来的性能开销。

上面的这个过程被称为基于长连接的命令传播,通过这种方式来保证第一次同步后的主从服务器的数据一致性。

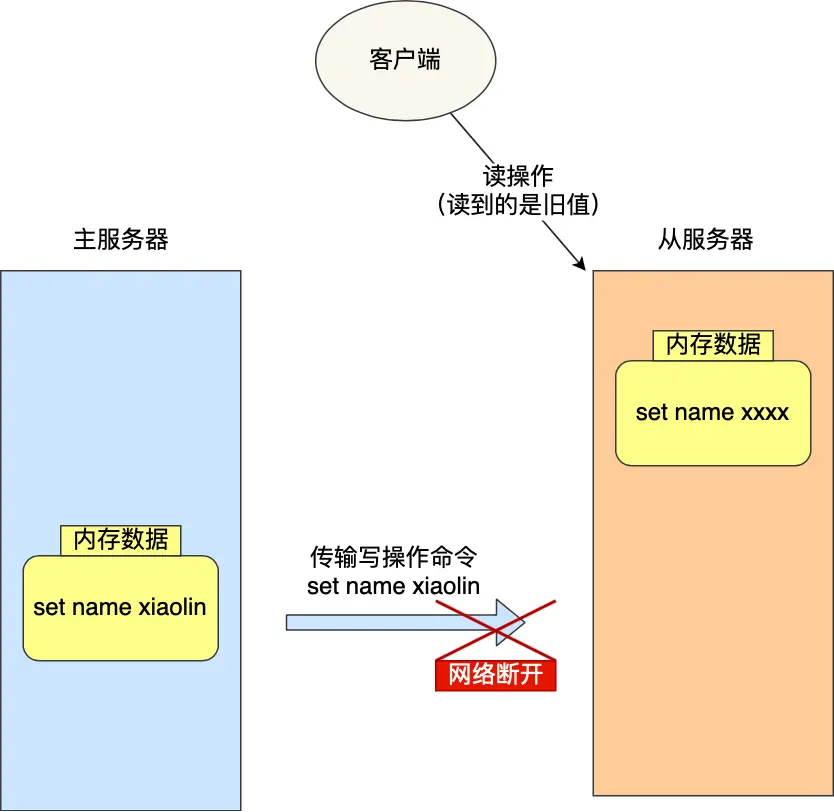

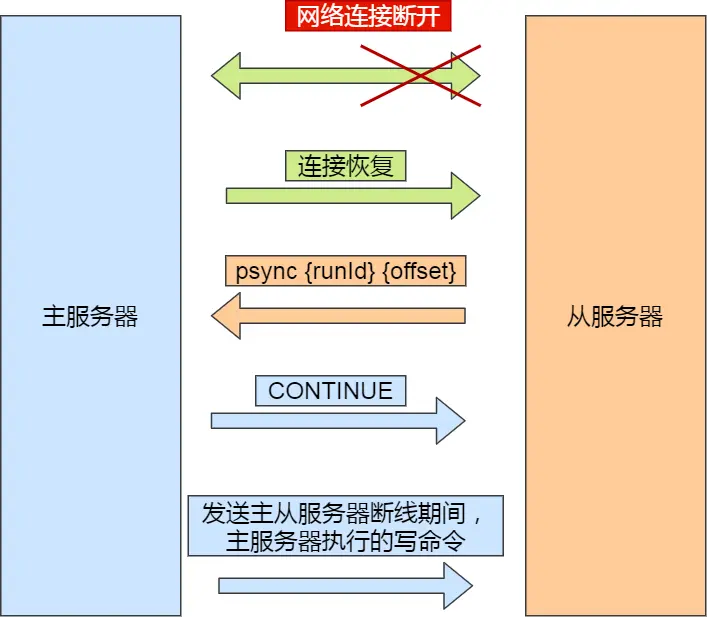

增量复制

主从服务器在第一次同步之后,就会建立一个tcp长连接完成命令传输。但是此时网络产生延迟或者断开。那么就不能进行命令传播了(这里的断开网络指的是主从服务器之间的同步被打断),那么客户端还是可以从从服务器读到旧的数据产生不一致性。

如果此时网络又恢复正常了,从服务器已经落后主服务器,要进行再次同步,这个时候用全局复制造成的开销会很大,可以采用增量复制的方法进行同步,只会把网络断开期间主服务器收到的写操作同步给从服务器,利用的就是offset之间的差值。

- 恢复连接后从服务器给主服务器发送id和offset

- 主服务器知道id是自己的,但是offest落后的有点多,这个时候就会计算自己的offset和从服务器给的offset之间差了多少,然后发送CONTINUE命令,告诉从服务器要发送增量数据。

- 从服务器重新执行这些命令

offset具体怎么计算?

- repl_backlog_buffer,是一个「环形」缓冲区,用于主从服务器断连后,从中找到差异的数据;

- replication offset,标记上面那个缓冲区的同步进度,主从服务器都有各自的偏移量,主服务器使用 master_repl_offset 来记录自己「写」到的位置,从服务器使用 slave_repl_offset 来记录自己「读」到的位置。

那 repl_backlog_buffer 缓冲区是什么时候写入的呢?

在主服务器进行命令传播时,不仅会将写命令发送给从服务器,还会将写命令写入到 repl_backlog_buffer 缓冲区里,因此 这个缓冲区里会保存着最近传播的写命令。

网络断开后,当从服务器重新连上主服务器时,从服务器会通过 psync 命令将自己的复制偏移量 slave_repl_offset 发送给主服务器,主服务器根据自己的 master_repl_offset 和 slave_repl_offset 之间的差距,然后来决定对从服务器执行哪种同步操作:

- 如果判断出从服务器要读取的数据还在 repl_backlog_buffer 缓冲区里,那么主服务器将采用增量同步的方式;

- 相反,如果判断出从服务器要读取的数据已经不存在 repl_backlog_buffer 缓冲区里,那么主服务器将采用全量同步的方式。(这是由于缓冲区是环形的,时间过长就会导致原来的数据被覆盖)

环形缓冲区repl_backlog_buffer

当主服务器在 repl_backlog_buffer 中找到主从服务器差异(增量)的数据后,就会将增量的数据写入到 replication buffer 缓冲区,这个缓冲区我们前面也提到过,它是缓存将要传播给从服务器的命令。

repl_backlog_buffer 缓行缓冲区的默认大小是 1M,并且由于它是一个环形缓冲区,所以当缓冲区写满后,主服务器继续写入的话,就会覆盖之前的数据。因此,当主服务器的写入速度远超于从服务器的读取速度,缓冲区的数据一下就会被覆盖。

那么在网络恢复时,如果从服务器想读的数据已经被覆盖了,主服务器就会采用全量同步,这个方式比增量同步的性能损耗要大很多。

因此,为了避免在网络恢复时,主服务器频繁地使用全量同步的方式,我们应该调整下 repl_backlog_buffer 缓冲区大小,尽可能的大一些,减少出现从服务器要读取的数据被覆盖的概率,从而使得主服务器采用增量同步的方式。

repl_backlog_buffer 缓冲区具体要调整到多大呢?

$$

second * write_size_per_second

$$

- second为从服务器掉线以后重新连上主服务器所需的平均时间(以秒计算)

- write_size_per_second为主服务器平均每秒产生的写命令数据量大小

环形缓冲区的大小不能低于平均掉线时间*主服务器平均每秒产生的数据量,要不然会频繁bgsave影响主进程,开销大

举个例子,如果主服务器平均每秒产生 1 MB 的写命令,而从服务器断线之后平均要 5 秒才能重新连接主服务器。

那么 repl_backlog_buffer 大小就不能低于 5 MB,否则新写地命令就会覆盖旧数据了。

当然,为了应对一些突发的情况,可以将 repl_backlog_buffer 的大小设置为此基础上的 2 倍,也就是 10 MB。

关于 repl_backlog_buffer 大小修改的方法,只需要修改配置文件里下面这个参数项的值就可以。 repl-backlog-size 1mb

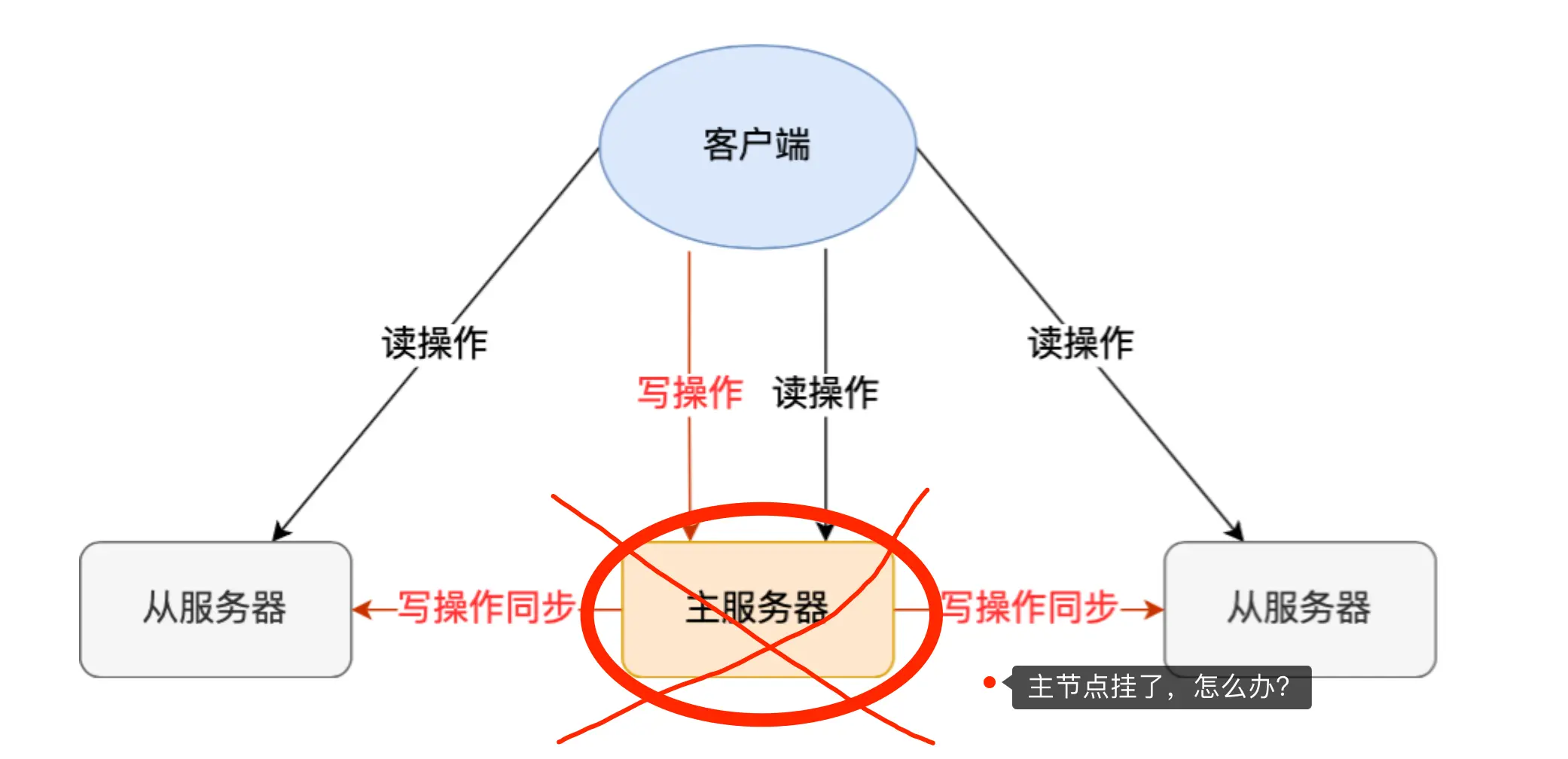

哨兵机制

在 Redis 的主从架构中,由于主从模式是读写分离的,如果主节点(master)挂了,那么将没有主节点来服务客户端的写操作请求,也没有主节点给从节点(slave)进行数据同步了。

这时如果要恢复服务的话,需要人工介入,选择一个「从节点」切换为「主节点」,然后让其他从节点指向新的主节点,同时还需要通知上游那些连接 Redis 主节点的客户端,将其配置中的主节点 IP 地址更新为「新主节点」的 IP 地址。

这样也不太“智能”了,要是有一个节点能监控「主节点」的状态,当发现主节点挂了,它自动将一个「从节点」切换为「主节点」的话,那么可以节省我们很多事情啊!

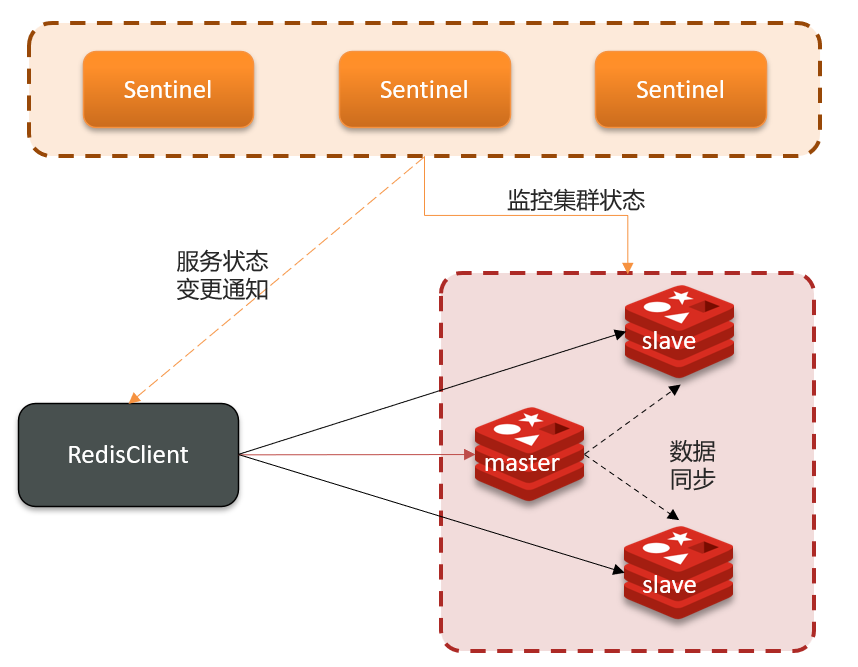

Redis 在 2.8 版本以后提供的哨兵(Sentinel)机制,它的作用是实现主从节点故障转移。它会监测主节点是否存活,如果发现主节点挂了,它就会选举一个从节点切换为主节点,并且把新主节点的相关信息通知给从节点和客户端

哨兵的功能

- 监控:Sentinel会定期检查master和slave是否按照预期工作(通过心跳机制)

- 自动故障恢复:如果master故障,就选举出一个slave作为新的master,然后进行主节点故障迁移

- 通知:当发生故障转移时,会将最新信息发送给Redis客户端

服务状态监控

Sentinel基于心跳机制ping-pong,每隔1秒向每个集群内的实例发送ping。

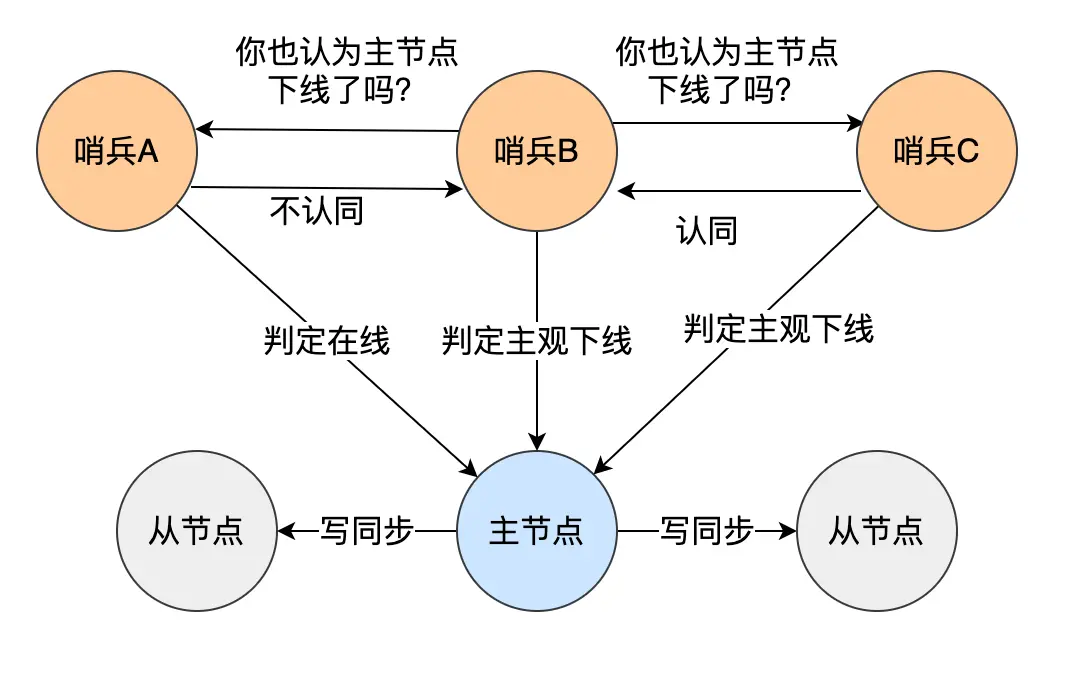

- 主观下线:如果某sentinel节点发现实例没有在规定时间内响应,那就标记成主观下线,这个规定的时间是配置项down-after-milliseconds 参数设定的,单位是毫秒。

- 客观下线:有的时候主节点其实并没有发生故障,只是因为网络拥塞,导致没有在规定时间响应Ping。为了减少误判的情况,哨兵不会之配置成一个节点(至少有三台机器来部署哨兵集群)如果超过指定数量(quorum)的哨兵认为该实例主观下线,那么该节点就是客观下线,那就被认为是故障。

哨兵会每隔 1 秒给所有主从节点发送 PING 命令,当主从节点收到 PING 命令后,会发送一个响应命令给哨兵,这样就可以判断它们是否在正常运行。

如果主节点或者从节点没有在规定的时间内响应哨兵的 PING 命令,哨兵就会将它们标记为「主观下线」。这个「规定的时间」是配置项 down-after-milliseconds 参数设定的,单位是毫秒。

之所以针对「主节点」设计「主观下线」和「客观下线」两个状态,是因为有可能「主节点」其实并没有故障,可能只是因为主节点的系统压力比较大或者网络发送了拥塞,导致主节点没有在规定时间内响应哨兵的 PING 命令。

所以,为了减少误判的情况,哨兵在部署的时候不会只部署一个节点,而是用多个节点部署成哨兵集群(最少需要三台机器来部署哨兵集群),通过多个哨兵节点一起判断,就可以就可以避免单个哨兵因为自身网络状况不好,而误判主节点下线的情况。同时,多个哨兵的网络同时不稳定的概率较小,由它们一起做决策,误判率也能降低。

具体是怎么判定主节点为「客观下线」的呢?

当一个哨兵判断主节点为「主观下线」后,就会向其他哨兵发起命令,其他哨兵收到这个命令后,就会根据自身和主节点的网络状况,做出赞成投票或者拒绝投票的响应。

当这个哨兵的赞同票数达到哨兵配置文件中的 quorum 配置项设定的值后,这时主节点就会被该哨兵标记为「客观下线」。

例如,现在有 3 个哨兵,quorum 配置的是 2,那么一个哨兵需要 2 张赞成票,就可以标记主节点为“客观下线”了。这 2 张赞成票包括哨兵自己的一张赞成票和另外两个哨兵的赞成票(包括自己的一票)。

PS:quorum 的值一般设置为哨兵个数的二分之一加 1,例如 3 个哨兵就设置 2。

哨兵判断完主节点客观下线后,哨兵就要开始在多个「从节点」中,选出一个从节点来做新主节点

由哪个哨兵进行主从故障转移?

假设刚刚在哨兵的内部已经将主节点标记成了客观下线,那么哨兵集群哪个节点来对其进行故障转移呢?

这个时候需要选举一个哨兵集群的leader来进行故障转移,但是在投票之前肯定需要一个候选者,这个候选者一般是首先发现主节点的哨兵。

那么怎么样成为leader呢,哨兵集群需要进行投票,每个哨兵只有一次投票机会,只有候选者能够投给自己(一般也只有一个候选者,除非出现同一时间点有两个哨兵发现了主节点故障发起主观下线)

在投票过程中,只要候选者达到以下条件就可以变成leader:

- 第一,拿到半数以上的赞成票

- 第二,票数还要同时大于等于quorum 值

如果某个时间点,刚好有两个哨兵节点判断到主节点为客观下线,那这时不就有两个候选者了?这时该如何决定谁是 Leader 呢?

每位候选者都会先给自己投一票,然后向其他哨兵发起投票请求。如果投票者先收到「候选者 A」的投票请求,就会先投票给它,如果投票者用完投票机会后,收到「候选者 B」的投票请求后,就会拒绝投票。这时,候选者 A 先满足了上面的那两个条件,所以「候选者 A」就会被选举为 Leader。

Redis 1 主 4 从,5 个哨兵,quorum 设置为 3,如果 2 个哨兵故障,当主节点宕机时,哨兵能否判断主节点“客观下线”?主从能否自动切换?

哨兵集群可以判定主节点“客观下线”。哨兵集群还剩下 3 个哨兵,当一个哨兵判断主节点“主观下线”后,询问另外 2 个哨兵后,有可能能拿到 3 张赞同票,这时就达到了 quorum 的值,因此,哨兵集群可以判定主节点为“客观下线”。

哨兵集群可以完成主从切换。当有个哨兵标记主节点为「客观下线」后,就会进行选举 Leader 的过程,因为此时哨兵集群还剩下 3 个哨兵,那么还是可以拿到半数以上(5/2+1=3)的票,而且也达到了 quorum 值,满足了选举 Leader 的两个条件,所以就能选举成功,因此哨兵集群可以完成主从切换。

如果 quorum 设置为 2,并且如果有 3 个哨兵故障的话。此时哨兵集群还是可以判定主节点为“客观下线”,但是哨兵不能完成主从切换了,大家可以自己推演下。

如果 quorum 设置为 3,并且如果有 3 个哨兵故障的话,哨兵集群即不能判定主节点为“客观下线”,也不能完成主从切换了。

可以看到,quorum 为 2 的时候,并且如果有 3 个哨兵故障的话,虽然可以判定主节点为“客观下线”,但是不能完成主从切换,这样感觉「判定主节点为客观下线」这件事情白做了一样,既然这样,还不如不要做,quorum 为 3 的时候,就可以避免这种无用功。

所以,quorum 的值建议设置为哨兵个数的二分之一加 1,例如 3 个哨兵就设置 2,5 个哨兵设置为 3,而且哨兵节点的数量应该是奇数。

主从故障转移的过程

主从故障转移操作包含以下四个步骤:

- 第一步:在已下线主节点(旧主节点)属下的所有「从节点」里面,挑选出一个从节点,并将其转换为主节点。

- 第二步:让已下线主节点属下的所有「从节点」修改复制目标,修改为复制「新主节点」;

- 第三步:将新主节点的 IP 地址和信息,通过「发布者/订阅者机制」通知给客户端;

- 第四步:继续监视旧主节点,当这个旧主节点重新上线时,将它设置为新主节点的从节点

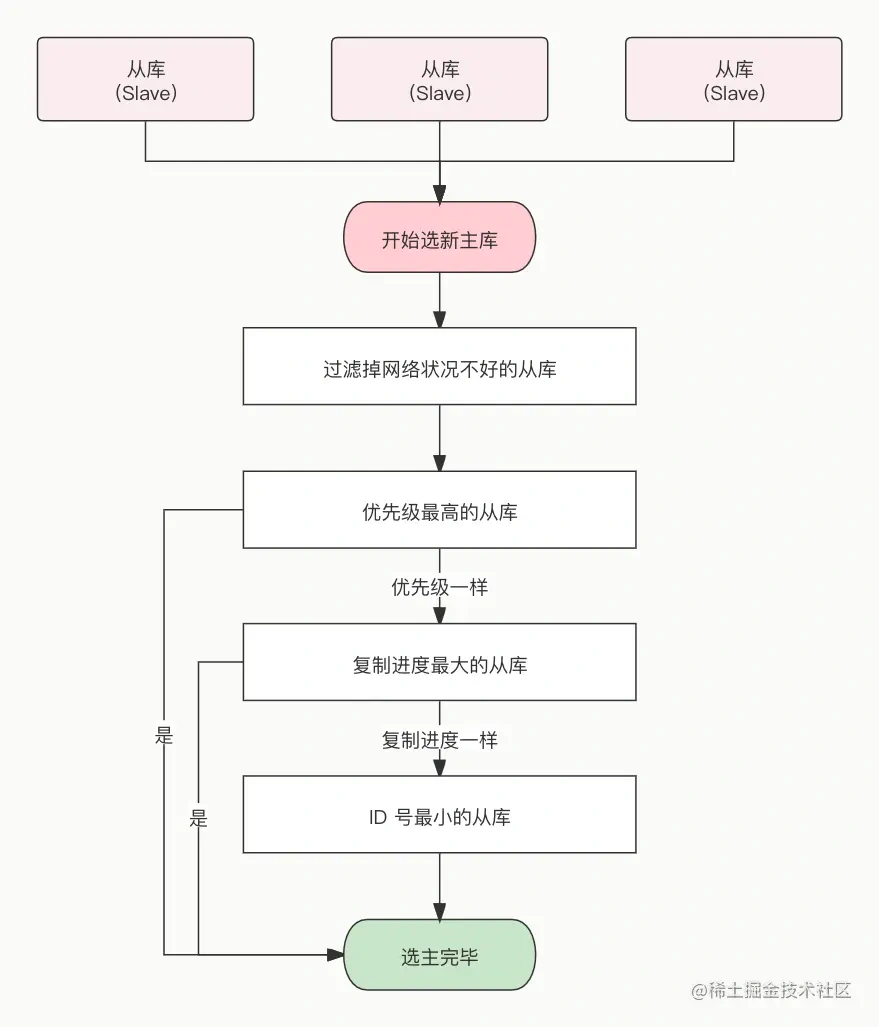

步骤一:选出新节点

故障转移操作第一步要做的就是在已下线主节点属下的所有「从节点」中,挑选出一个状态良好、数据完整的从节点,然后向这个「从节点」发送 SLAVEOF no one 命令,将这个「从节点」转换为「主节点」。

那么多「从节点」,到底选择哪个从节点作为新主节点的?

随机的方式好吗?随机的方式,实现起来很简单,但是如果选到一个网络状态不好的从节点作为新主节点,那么可能在将来不久又要做一次主从故障迁移。

所以,我们首先要把网络状态不好的从节点给过滤掉。首先把已经下线的从节点过滤掉,然后把以往网络连接状态不好的从节点也给过滤掉。

怎么判断从节点之前的网络连接状态不好呢?

Redis 有个叫 down-after-milliseconds * 10 配置项,其 down-after-milliseconds 是主从节点断连的最大连接超时时间。如果在 down-after-milliseconds 毫秒内,主从节点都没有通过网络联系上,我们就可以认为主从节点断连了。如果发生断连的次数超过了 10 次,就说明这个从节点的网络状况不好,不适合作为新主节点。

至此,我们就把网络状态不好的从节点过滤掉了,接下来要对所有从节点进行三轮考察:优先级、复制进度、ID 号。在进行每一轮考察的时候,哪个从节点优先胜出,就选择其作为新主节点。

- 第一轮考察:哨兵首先会根据从节点的优先级来进行排序,优先级越小排名越靠前,

- 第二轮考察:如果优先级相同,则查看复制的下标,哪个从「主节点」接收的复制数据多,哪个就靠前(也就是offset更靠近主节点那个)

- 第三轮考察:如果优先级和下标都相同,就选择从节点 ID 较小的那个。

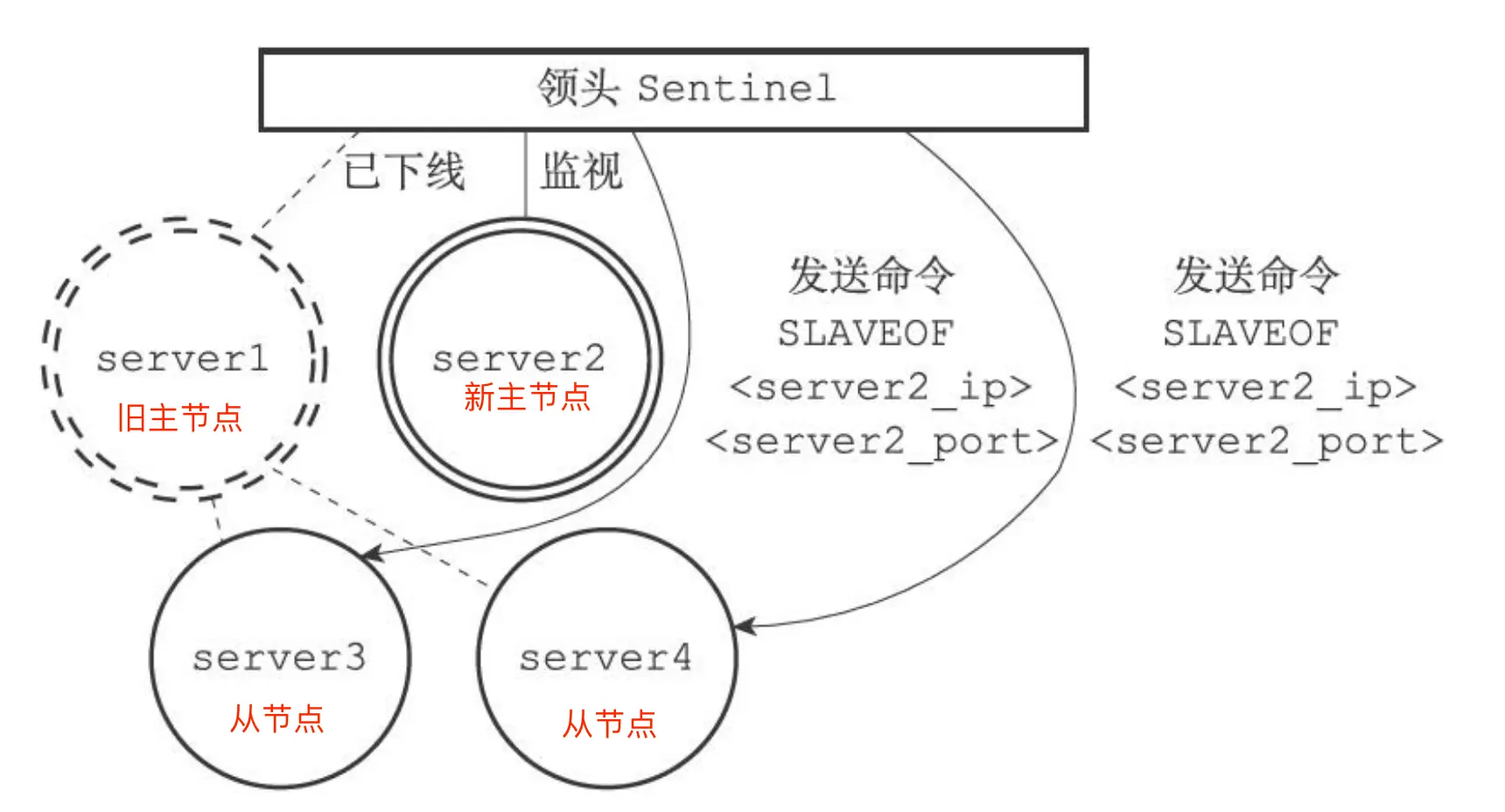

步骤二:将从节点指向主节点

当新主节点出现之后,哨兵 leader 下一步要做的就是,让已下线主节点属下的所有「从节点」指向「新主节点」,这一动作可以通过向「从节点」发送 SLAVEOF 命令来实现。

如下图,哨兵 leader 向所有从节点(server3 和 server4)发送 SLAVEOF ,让它们成为新主节点的从节点。

步骤三:通知客户的主节点已更换

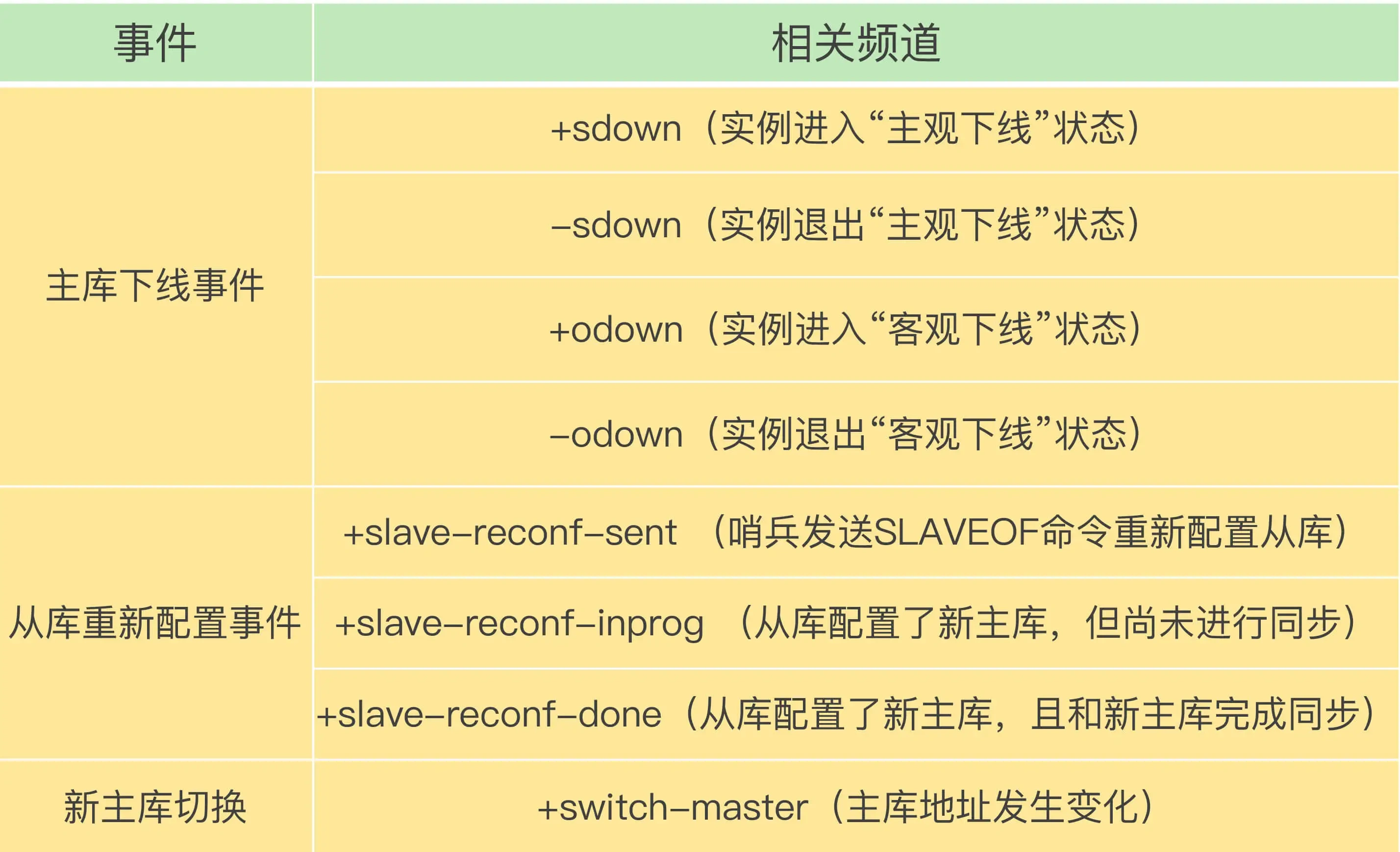

经过前面一系列的操作后,哨兵集群终于完成主从切换的工作,那么新主节点的信息要如何通知给客户端呢?

这主要通过 Redis 的发布者/订阅者机制来实现的。每个哨兵节点提供发布者/订阅者机制,客户端可以从哨兵订阅消息。

类似kafka那种订阅机制,也可以想象成计网的那种广播信道,每个哨兵进行广播,客户端接受相应表头的时间,完成通知

哨兵提供的消息订阅频道有很多,不同频道包含了主从节点切换过程中的不同关键事件,几个常见的事件如下:

客户端和哨兵建立连接后,客户端会订阅哨兵提供的频道。主从切换完成后,哨兵就会向 +switch-master 频道发布新主节点的 IP 地址和端口的消息,这个时候客户端就可以收到这条信息,然后用这里面的新主节点的 IP 地址和端口进行通信了。

通过发布者/订阅者机制机制,有了这些事件通知,客户端不仅可以在主从切换后得到新主节点的连接信息,还可以监控到主从节点切换过程中发生的各个重要事件。这样,客户端就可以知道主从切换进行到哪一步了,有助于了解切换进度。

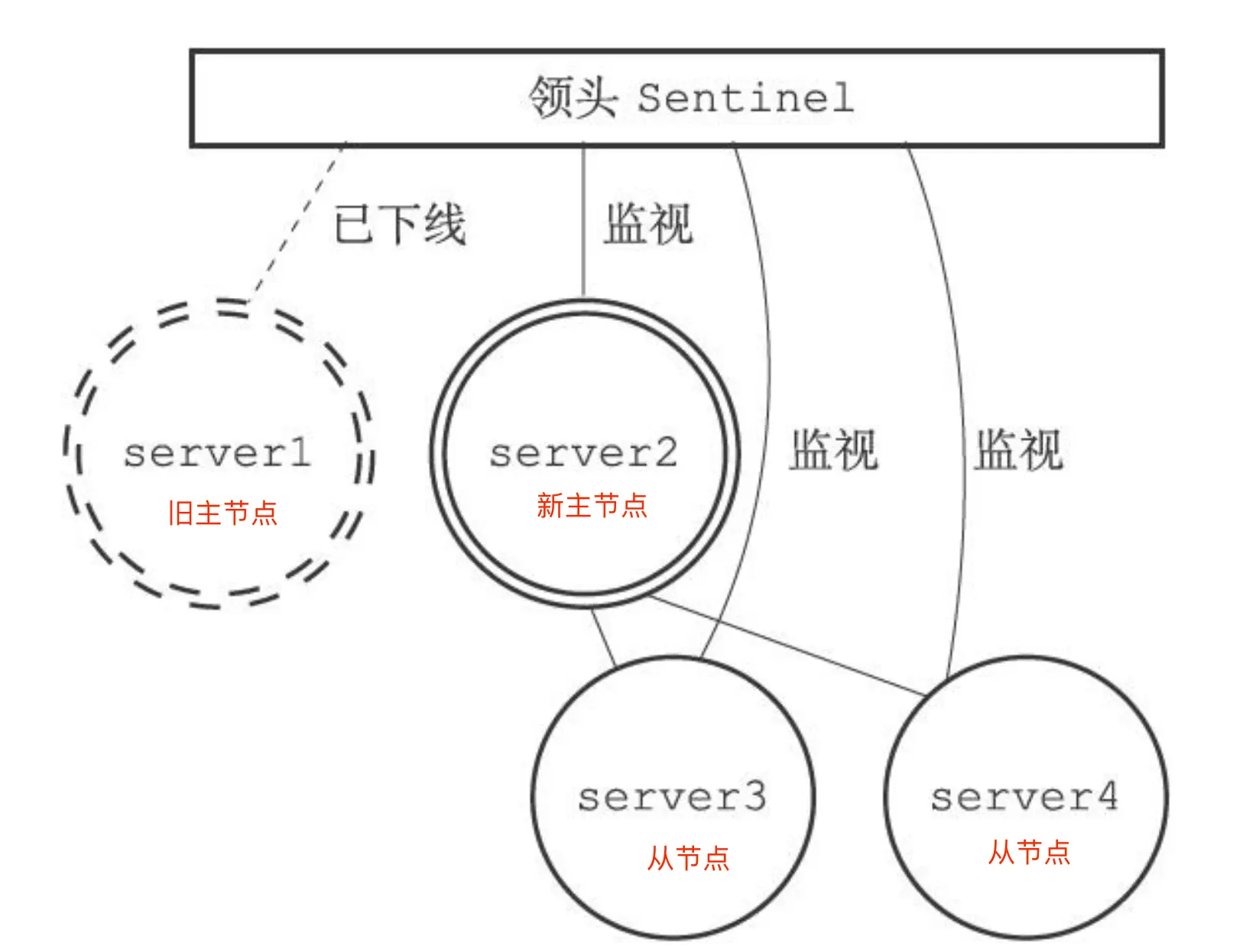

步骤四:将旧主节点变为从节点

故障转移操作最后要做的是,继续监视旧主节点,当旧主节点重新上线时,哨兵集群就会向它发送 SLAVEOF 命令,让它成为新主节点的从节点

至此,整个主从节点的故障转移的工作结束